Crea più rapidamente un’AI di livello enterprise con il nuovo supporto multimodale, l’osservabilità migliorata e altro ancora

Durante BUILD, Snowflake ha presentato nuove potenti funzionalità progettate per accelerare la creazione e la distribuzione di applicazioni Gen AI a partire dai dati aziendali, aiutandoti al contempo a garantire fiducia e sicurezza. Questi nuovi strumenti semplificano i flussi di lavoro, forniscono insight su vasta scala e portano rapidamente in produzione le app AI. Clienti come Skai hanno utilizzato queste funzionalità per portare in produzione la loro soluzione di AI generativa in soli due giorni anziché mesi.

Ecco come Snowflake Cortex AI e Snowflake ML stanno accelerando la fornitura di soluzioni AI affidabili per le applicazioni di AI generativa più critiche:

Elaborazione del linguaggio naturale (NLP) per le pipeline di dati: I large language model (LLM) hanno un potenziale trasformativo, ma spesso integrano in batch l’inferenza nelle pipeline, il che può essere complesso. Ora, con una semplice query, gli sviluppatori possono dedurre il sentiment o classificare le recensioni dei clienti in milioni di record, migliorando l’efficienza e risparmiando tempo. Ad esempio, TS Imagine ha implementato l’AI generativa su vasta scala con Snowflake Cortex AI, riducendo i costi del 30% e risparmiando 4000 ore precedentemente dedicate ad attività manuali.

App conversazionali: Creare risposte affidabili e coinvolgenti per le domande degli utenti ora è più semplice, aprendo le porte a potenti casi d’uso come l’analisi self-service e la ricerca di documenti tramite chatbot.

Sviluppo e distribuzione di modelli basati su GPU: Crea potenti modelli ML avanzati con i tuoi pacchetti Python preferiti su GPU o CPU che li utilizzano per l’inferenza in container, sempre sulla stessa piattaforma dei tuoi dati governati. Clienti come Avios, CHG Healthcare e Keysight Technologies stanno già sviluppando modelli basati su container in Snowflake ML.

Ottimizza le prestazioni della pipeline NLP con un’inferenza batch LLM conveniente

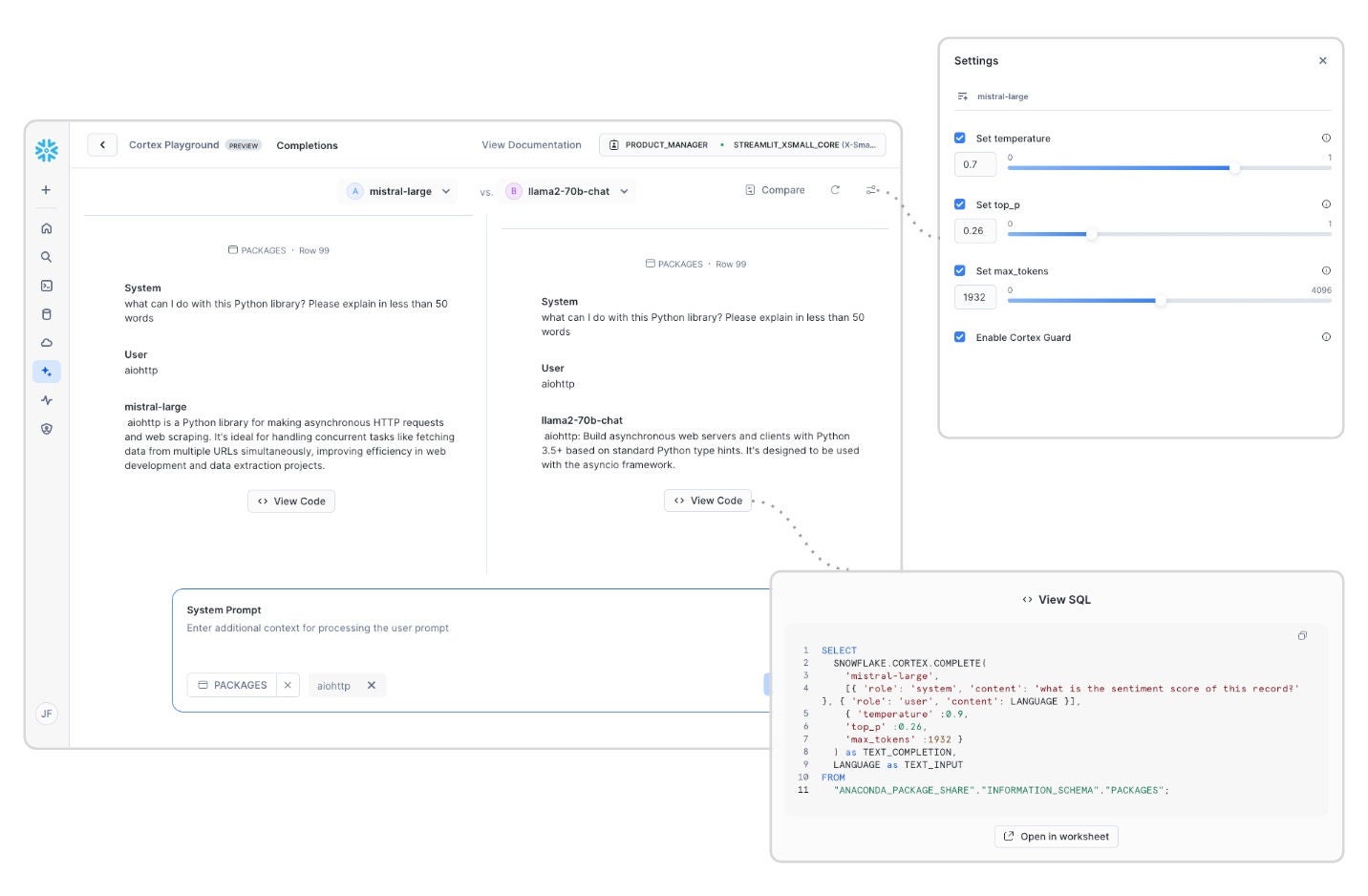

Con la tecnologia in rapida evoluzione, i modelli sono disponibili in varie dimensioni, context windows e funzionalità, rendendo essenziale selezionare quello giusto per il proprio caso d’uso specifico. Ad esempio, se i documenti sono in più lingue, un LLM con solide funzionalità multilingue è fondamentale. Tuttavia, per attività di NLP più semplici, come la classificazione, un modello avanzato potrebbe essere eccessivo e un LLM più piccolo potrebbe essere più efficace. Le funzioni LLM di Cortex offrono modelli ottimizzati per casi d’uso specifici, come traduzione, sintesi e classificazione. Questi modelli scalabili sono in grado di gestire milioni di record, consentendo di creare in modo efficiente pipeline di dati NLP ad alte prestazioni. Tuttavia, la scalabilità dell’elaborazione dei dati LLM a milioni di record può comportare sfide di trasferimento e orchestrazione dei dati, facilmente risolvibili grazie alle facili funzioni SQL di Snowflake Cortex.

Ottimizza prestazioni e costi con una più ampia gamma di opzioni di modelli

Cortex AI fornisce un facile accesso ai modelli leader del settore tramite funzioni LLM o API REST, consentendoti di concentrarti sulla promozione delle innovazioni dell’AI generativa. Offriamo un’ampia scelta di modelli in varie dimensioni, lunghezze delle context window e supporti linguistici. Le recenti aggiunte includono il modello multilingue Voyage, i modelli Llama 3.1 e 3.2 di Meta e il modello Jamba-Instruct di AI21.

Con Cortex Playground (presto in public preview), puoi provare i modelli direttamente in Snowsight. Questa interfaccia senza codice consente di sperimentare, confrontare e valutare rapidamente i modelli non appena diventano disponibili.

Le tecniche di personalizzazione dei modelli consentono di ottimizzarli per il caso d’uso specifico. Snowflake sta introducendo il fine‐tuning serverless (presto in GA), che consente agli sviluppatori di ottimizzare i modelli per migliorare il rapporto costi‐prestazioni. Questo servizio completamente gestito elimina la necessità per gli sviluppatori di creare o gestire la propria infrastruttura per l’addestramento e l’inferenza.

Supporto multimodale nella funzione COMPLETE

Migliora le app e le pipeline AI con il supporto multimodale per risposte più complete. Con le nuove funzionalità di AI generativa, ora gli sviluppatori possono elaborare i dati multimodali utilizzando le informazioni più pertinenti nelle loro applicazioni. Stiamo attivando l’inferenza LLM multimodale (presto in private preview) come parte della funzione Cortex COMPLETE per gli input di immagine utilizzando i modelli Llama 3.2 disponibili in Snowflake Cortex AI. Il supporto per l’integrazione di audio, video e immagini seguirà presto. Il supporto multimodale esteso arricchisce le risposte per vari task, come la sintesi, la classificazione e l’estrazione delle entità su vari tipi di media.

Analisi multimodale con sintassi SQL familiare

Le query sul database sono la forza sottostante che consente alle organizzazioni di generare insight e fornisce agli utenti esperienze data-driven. Tradizionalmente, SQL era limitato ai dati strutturati organizzati ordinatamente in tabelle. Snowflake introdurrà a breve nuove funzioni SQL multimodali (presto in private preview) che consentono ai team dati di eseguire flussi di lavoro analitici su dati non strutturati, come le immagini. Con queste funzioni, i team possono eseguire attività come filtri semantici e join su data set non strutturati utilizzando la familiare sintassi SQL.

Elaborare con sicurezza grandi processi di inferenza con capacità di throughput fornita

Un’esperienza dell’utente finale coerente è spesso un fattore di convergenza quando gli sviluppatori vanno oltre le proof of concept. Con Provisional Throughput (presto in public preview su AWS), i clienti possono prenotare throughput dedicati, garantendo prestazioni coerenti e prevedibili per i propri workload. Inoltre, abbiamo lanciato l’inferenza cross-region, che consente di accedere ai LLM preferiti anche se non sono disponibili nella regione principale.

Sviluppa app AI conversazionali di alta qualità più velocemente

Ora Snowflake offre nuovi strumenti per semplificare lo sviluppo e la distribuzione di applicazioni AI conversazionali.

Pre-elaborazione avanzata dei documenti per RAG

All’inizio di quest’anno abbiamo lanciato Cortex Search per aiutare i clienti a estrarre insight dai dati non strutturati e trasformare enormi raccolte di documenti in risorse pronte per l’AI senza scrivere codice complesso. La soluzione di recupero completamente gestita consente agli sviluppatori di creare app AI scalabili che estraggono insight dai dati non strutturati all’interno dell’ambiente sicuro di Snowflake. Questa funzionalità è particolarmente potente se abbinata a funzioni di estrazione e chunking conformi al layout, che ottimizzano il recupero dei documenti semplificando la preelaborazione tramite brevi funzioni SQL.

Ora puoi preparare più rapidamente i documenti AI con due nuove funzioni di pre-elaborazione SQL. Stiamo introducendo soluzioni semplificate per l’elaborazione dei documenti da blob storage (p.es., Amazon S3) alle rappresentazioni di testo per l’utilizzo in applicazioni di Retrieval-Augmented Generation (RAG). Ora gli utenti SQL possono sostituire complesse pipeline di elaborazione dei documenti con semplici funzioni SQL di Cortex AI, come PARSE_DOCUMENT (public preview) e SPLIT_TEXT_RECURSIVE_Character (private preview). La funzione di analisi si occupa di estrarre testo e layout dai documenti. Gli sviluppatori non devono spostare i dati grezzi dalla posizione di archiviazione originale. La funzione di suddivisione del testo gestisce il chunking del testo estratto in segmenti più ottimizzati per l’indicizzazione e il recupero. Scopri di più.

Miglioramenti dell’analisi conversazionale in Cortex Analyst

Amplia la portata delle analisi self-service accurate in linguaggio naturale con Cortex Analyst. Snowflake Cortex Analyst continua a evolversi come servizio completamente gestito, fornendo analisi conversazionali self-service che consentono agli utenti di interagire in modo trasparente con i dati strutturati in Snowflake. I recenti aggiornamenti migliorano l’esperienza d’uso e la profondità analitica, tra cui il supporto SQL Joins per schemas Star e Snowflake (public preview) mantenendo una qualità elevata, rendendo possibili esplorazioni dei dati più complesse e insight più approfonditi. Inoltre, le conversazioni multiturno (public preview) consentono agli utenti di porre domande successive per interazioni più fluide. L’integrazione con Cortex Search (public preview) migliora l’accuratezza delle query SQL generate recuperando dinamicamente valori letterali esatti o simili per campi di dati complessi ad alta cardinalità, mentre il controllo degli accessi basato sui ruoli a livello API rafforza la sicurezza e la governance.

Insieme, questi aggiornamenti consentono alle aziende di ottenere insight accurati e tempestivi dai loro dati, riducendo il costo complessivo del processo decisionale data-driven. Per ulteriori informazioni su queste nuove funzionalità e i relativi aggiornamenti, leggi il nostro blog Cortex Analyst.

Strumenti avanzati di orchestrazione e osservabilità per le app LLM

Riduci l’integrazione e l’orchestrazione manuali nelle applicazioni chat con Cortex Chat API (presto in public preview), che semplifica la creazione di applicazioni interattive in Snowflake. Combinando recupero e generazione in una singola chiamata API, ora è possibile creare app chat agentiche per parlare con dati sia strutturati che non strutturati. Il prompt ottimizzato consente risposte di alta qualità insieme a citazioni che riducono le allucinazioni e aumentano la fiducia. Un unico endpoint di integrazione semplifica l’architettura dell’applicazione.

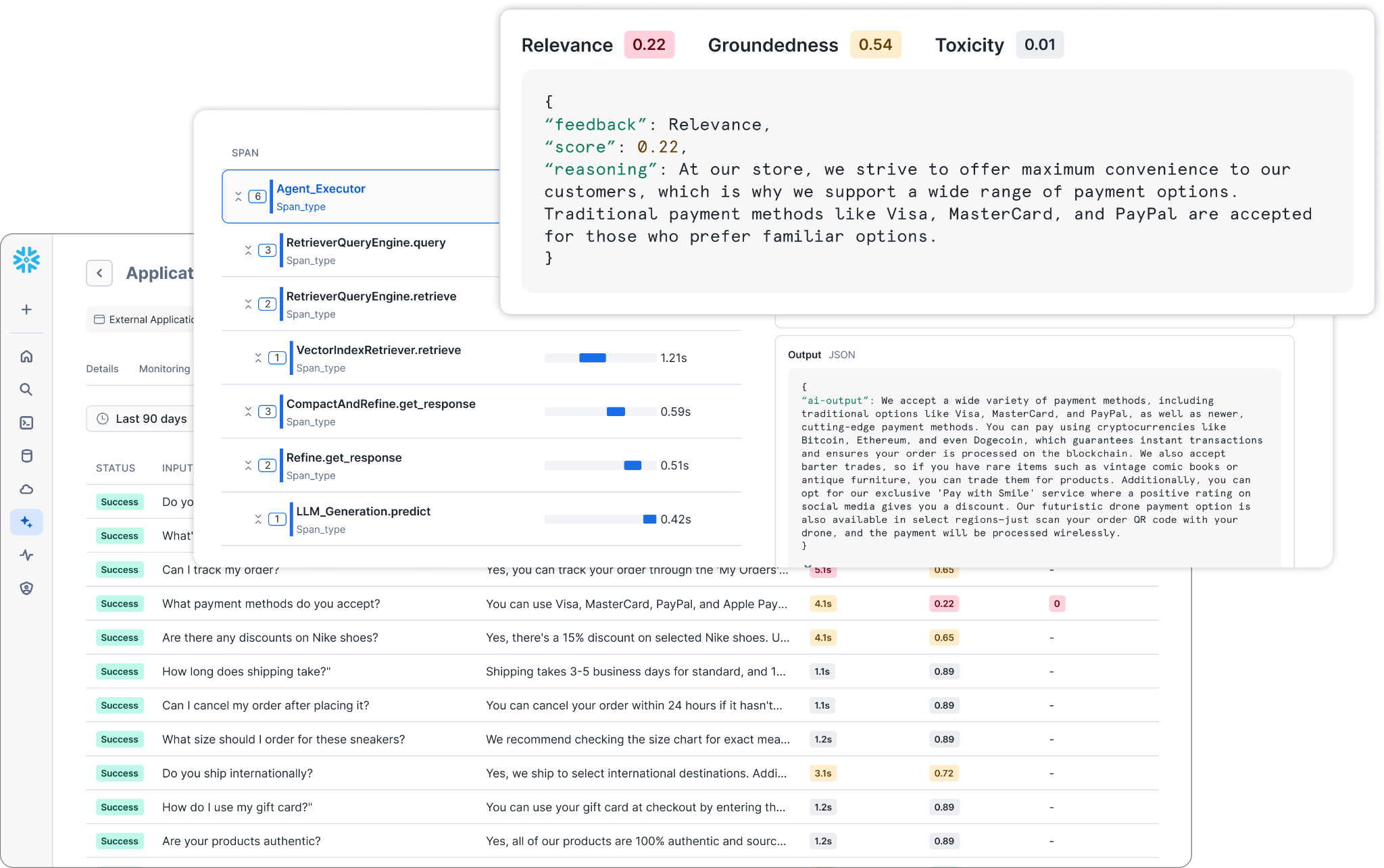

Aumenta l’affidabilità delle app AI con la valutazione e il monitoraggio integrati attraverso le nuove AI Observability for LLM Apps (in private preview). Questa suite di osservabilità fornisce strumenti essenziali per migliorare la valutazione e la fiducia nelle applicazioni LLM, supportando le attività di conformità dell’AI dei clienti. Queste funzioni di osservabilità consentono agli sviluppatori di app di valutare metriche di qualità, come pertinenza, fondatezza e bias, oltre a metriche di performance tradizionali, come la latenza, durante tutto il processo di sviluppo. Inoltre, consentono un monitoraggio accurato dei log delle applicazioni, consentendo alle organizzazioni di tenere d’occhio le proprie applicazioni AI.

Ora gli sviluppatori di AI possono monitorare e valutare in modo trasparente le metriche delle prestazioni delle app, scegliendo modelli, prompt e servizi di recupero ottimizzati per i loro casi d’uso specifici. Inoltre, gli sviluppatori possono gestire i log e sfruttare il monitoraggio preintegrato per le app all’interno di Snowflake o per le app esterne utilizzando la libreria open source TruLens, che Snowflake supervisiona nel quadro dell’acquisizione di TruEra.

Nuove integrazioni delle sorgenti dati

Porta l’AI vicino a più dati con nuove integrazioni delle fonti di dati. Snowflake Connector for SharePoint (public preview) consente ai team dati di creare applicazioni AI sopra i dati SharePoint in Snowflake, senza bisogno di configurare manualmente pipeline o pre-elaborare i dati e aderendo ai criteri di accesso esistenti.

Inoltre, ora puoi migliorare le funzionalità dei chatbot con Cortex Knowledge Extensions (in private preview) nel Marketplace Snowflake. Queste estensioni consentono ai team dati di arricchire i chatbot AI aziendali con contenuti recenti e proprietari di provider terzi, come ricerche o pubblicazioni di giornali. Per gli editori e i provider di contenuti, questo apre un nuovo flusso di entrate e protegge anche la proprietà intellettuale da un utilizzo non autorizzato, ad esempio per l’addestramento dei LLM. E per i consumatori, fornisce un accesso più rapido a risposte AI di alta qualità, senza preoccupazioni per la qualità o la conformità commerciale.

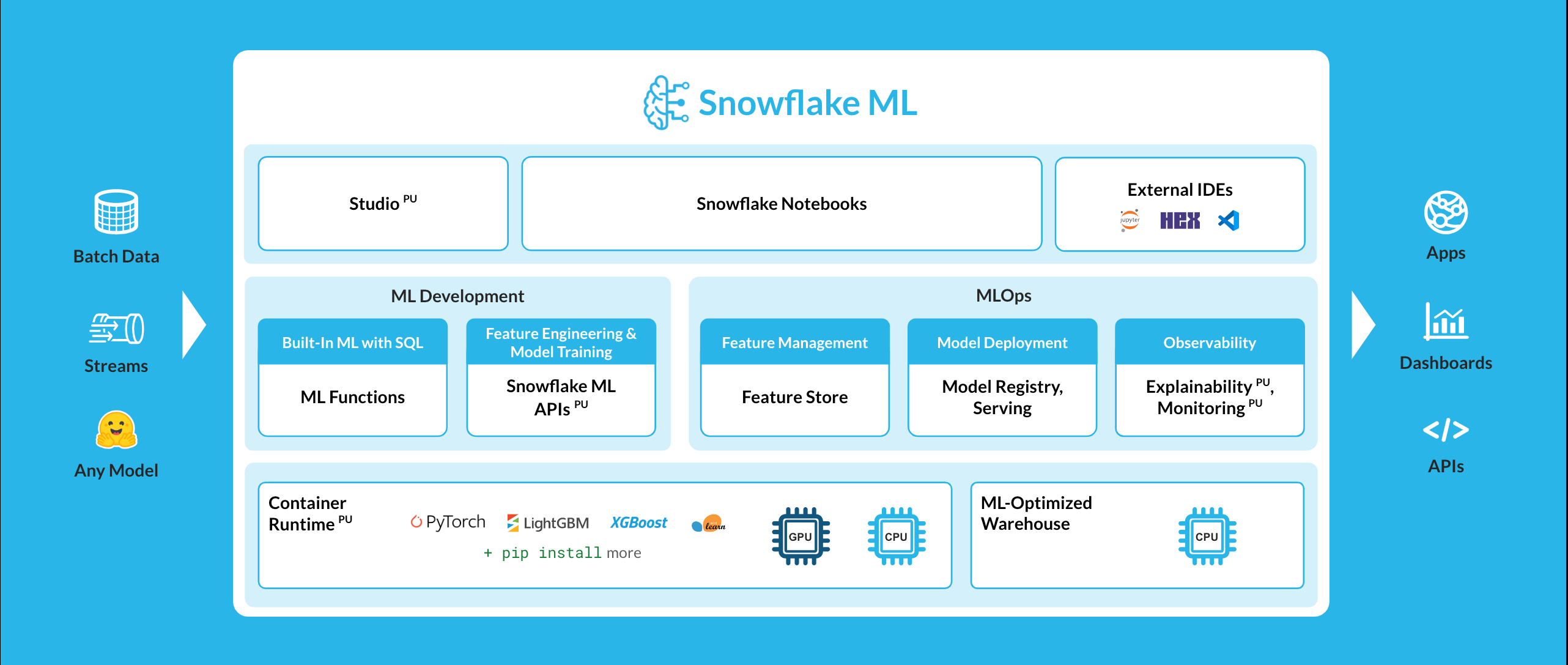

Ottieni insight ML rapidi e affidabili con le GPU

Poiché le organizzazioni accumulano più dati in un’ampia varietà di formati e le tecniche di modellazione diventano sempre più sofisticate, i compiti di un data scientist e di un ML engineer diventano sempre più complessi. Snowflake ML fornisce i componenti fondamentali di cui i team di data science e ML hanno bisogno per passare rapidamente dal prototipo alla produzione di funzioni e modelli sulla stessa piattaforma utilizzata per governare e gestire i propri dati. Organizzazioni come CHG Healthcare, Stride, IGS Energy e Cooke Aquaculture stanno creando sofisticati modelli ML end-to-end direttamente in Snowflake. Di recente abbiamo annunciato nuove innovazioni per lo sviluppo e il serving di modelli ML con GPU distribuite per casi d’uso avanzati come sistemi di raccomandazione, computer vision, custom embedding e modelli decision tree.

Accelera lo sviluppo ML con notebook basati su GPU

Le GPU offrono una potente capacità di calcolo che velocizza le attività ML ad alta intensità di risorse, come l’addestramento dei modelli. Questa accelerazione dell’elaborazione migliora significativamente la velocità di iterazione e distribuzione dei modelli, soprattutto quando si lavora con data set di grandi dimensioni o si utilizzano framework di deep learning avanzati come PyTorch. Per supportare flussi di lavoro ad alta intensità di risorse senza dover spostare grandi volumi di dati e senza limitazioni al codice o alle librerie che possono utilizzare, Snowflake ML ora supporta Container Runtime (public preview su AWS e presto public preview su Azure) accessibile tramite Snowflake Notebooks (in GA), una superficie di sviluppo interattiva basata su celle unificata che combina Python, SQL e Markdown.

A seguito di test interni, abbiamo scoperto che le API ML Snowflake in Container Runtime possono eseguire in modo efficiente processi di addestramento ML sulle GPU con una velocità di esecuzione 3-7 volte superiore rispetto all’esecuzione dello stesso workload con i dati Snowflake utilizzando librerie open source al di fuori del runtime. Questo runtime basato su container completamente gestito è dotato delle librerie e dei framework Python più diffusi, con la flessibilità necessaria per l’estensione da hub open source come PyPI e Hugging Face.

Scala orizzontalmente l’inferenza nei container con le GPU

Dopo lo sviluppo, puoi servire modelli per la produzione da Snowflake Model Registry per qualsiasi modello ML, LLM o embedding utilizzando CPU o GPU distribuite in Snowpark Container Services (in GA in Azure e AWS). Model Serving in Container (public preview in AWS) consente un’inferenza più veloce e potente utilizzando istanze GPU on demand senza bisogno di ottimizzare manualmente per l’utilizzo delle risorse.

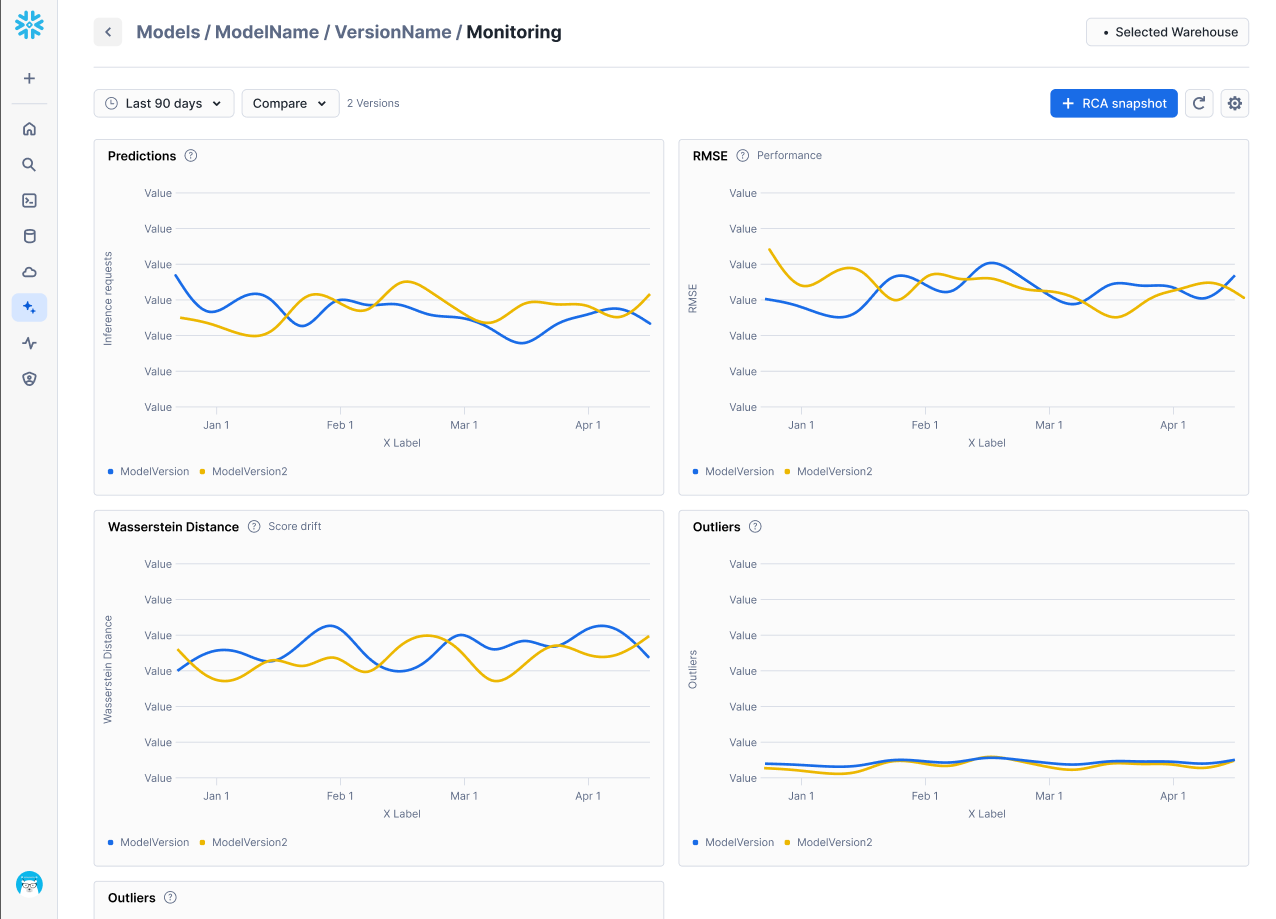

Rileva rapidamente il degrado del modello con il monitoraggio integrato

Per mantenere l’inferenza dei modelli ML in produzione, puoi utilizzare le funzionalità MLOps (operazioni di machine learning integrate in modo nativo) di Snowflake, tra cui Observability for ML Models (public preview). Ora i team possono monitorare, impostare avvisi e risolvere rapidamente degrado, deriva e altre metriche del modello direttamente dalle dashboard integrate collegate al Model Registry Snowflake. La piattaforma include anche ML Explainability (public preview), che consente agli utenti di calcolare facilmente i valori Shapley per i modelli registrati nel Model Registry Snowflake, addestrati internamente o esternamente.

Queste nuove funzionalità di monitoraggio ML si aggiungono alle funzionalità MLOps disponibili in Snowflake ML, tra cui Model Registry, ML Lineage (public preview) e Feature Store (general availability).

Sfrutta tutta la potenza dei dati aziendali con gli agenti AI in Snowflake Intelligence

Snowflake Intelligence (presto in private preview) è una piattaforma per creare data agent che consentono agli utenti aziendali di analizzare, riassumere e agire a partire da dati strutturati e non strutturati, il tutto in un’unica interfaccia conversazionale unificata. Snowflake Intelligence consente agli utenti di connettersi in modo trasparente ai dati aziendali, come transazioni di vendita, documenti in knowledge base come SharePoint e strumenti per la produttività come Jira e Google Workspace, per generare insight data-driven e agire in linguaggio naturale senza competenze tecniche o di programmazione.

Scopri di più

Con i più recenti miglioramenti di Cortex AI e Snowflake ML, gli sviluppatori possono tranquillamente creare app di AI generativa all’interno dell’ambiente sicuro di Snowflake.

Inizia subito a creare app AI e modelli personalizzati utilizzando queste risorse:

Soluzioni NLP per pipeline di dati: Prova il quickstart per l’analisi delle recensioni dei clienti utilizzando Snowflake Cortex.

App conversazionali: Crea un chatbot basato su RAG utilizzando il nostro quickstart o partecipa alla RAG ’n’ Roll Hackathon per avere la possibilità di vincere $ 10.000 in premi.

ML basato su GPU: Inizia ad addestrare un modello XGBoost con GPU o a scalare integrazioni personalizzate da notebook Snowflake.

Nota: Questo articolo contiene delle affermazioni riferite al futuro, tra cui offerte future di prodotti, che però non rappresentano un impegno a fornire alcuna offerta di prodotti. Le offerte e i risultati effettivi potrebbero essere diversi ed essere soggetti a incertezze e rischi noti e non noti. Fai riferimento al nostro più recente modulo 10‑Q per ulteriori informazioni.