Schnellere Entwicklung von KI auf Unternehmensebene dank neuer multimodaler Unterstützung, verbesserter Beobachtbarkeit und mehr

Bei Snowflake BUILD stellen wir Ihnen leistungsstarke neue Funktionen vor, mit denen Sie generative KI-Anwendungen schneller auf Unternehmensdaten aufbauen und bereitstellen können, ohne dabei das Vertrauen und die Sicherheit zu gefährden. Diese neuen Tools optimieren Workflows, liefern Einblicke in großem Umfang und bringen KI-Apps schnell in Produktion. Kunden wie Skai nutzen diese Funktionen, um ihre GenAI-Lösung in nur zwei Tagen statt in Monaten in Produktion zu bringen.

So beschleunigen Snowflake Cortex AI und Snowflake ML die Bereitstellung zuverlässiger KI-Lösungen für die kritischsten GenAI-Anwendungen:

NLP (Natural Language Processing) für Daten-Pipelines: Large Language Models (LLMs) bergen ein transformatives Potenzial, aber sie integrieren oft Batch-Inferenzen in Pipelines, was umständlich sein kann. Mit einer einfachen Abfrage können Entwickler:innen nun Stimmungen ableiten oder Kundenbewertungen über Millionen von Datensätzen hinweg kategorisieren, was die Effizienz steigert und Zeit spart. So konnte TS Imagine beispielsweise mit Snowflake Cortex AI skalierbare generative KI implementieren, wodurch die Kosten um 30 % gesenkt und 4.000 Stunden eingespart wurden, die zuvor für manuelle Aufgaben aufgewendet wurden.

Dialogorientierte Apps: Zuverlässige und ansprechende Antworten auf Benutzerfragen zu erstellen, ist jetzt einfacher und öffnet die Tür für leistungsstarke Anwendungsfälle wie Self-Service-Analytics und Dokumentensuche über Chatbots.

GPU-basierte Modellentwicklung und -bereitstellung: Erstellen Sie leistungsstarke, fortschrittliche ML-Modelle mit Ihren bevorzugten Python-Paketen auf GPUs oder CPUs, die sie zur Inferenz in Containern bereitstellen – alles auf derselben Plattform wie Ihre kontrollierten Daten. Kunden wie Avios, CHG Healthcare und Keysight Technologies entwickeln bereits containerbasierte Modelle in Snowflake ML.

Performance der NLP-Pipeline mit kostengünstiger LLM-Batch-Inferenz optimieren

Dank der sich rasant weiterentwickelnden Technologie sind Modelle in verschiedenen Größen, Kontextfenstern und Funktionen verfügbar, sodass es unerlässlich ist, das richtige für Ihren spezifischen Anwendungsfall auszuwählen. Wenn Ihre Dokumente beispielsweise in mehreren Sprachen vorliegen, ist ein LLM mit starken mehrsprachigen Fähigkeiten entscheidend. Für einfachere NLP-Aufgaben wie die Klassifizierung ist ein fortgeschrittenes Modell jedoch möglicherweise übertrieben und ein kleineres LLM effektiver. Cortex LLM-Funktionen bieten Modelle, die für spezifische Anwendungsfälle optimiert sind, wie z. B. Übersetzung, Zusammenfassung und Klassifizierung. Diese skalierbaren Modelle können Millionen von Datensätzen verarbeiten und ermöglichen so den effizienten Aufbau leistungsstarker NLP-Daten-Pipelines. Die Skalierung der LLM-Datenverarbeitung auf Millionen von Datensätzen kann jedoch Herausforderungen bei der Datenübertragung und Orchestrierung mit sich bringen, die durch die benutzerfreundlichen SQL-Funktionen in Snowflake Cortex problemlos gelöst werden können.

Performance- und Kostenoptimierung mit einer größeren Auswahl an Modelloptionen

Cortex AI bietet einfachen Zugriff auf branchenführende Modelle über LLM-Funktionen oder REST-APIs, sodass Sie sich auf die Förderung von GenAI-Innovationen konzentrieren können. Wir bieten eine große Auswahl an Modellen in verschiedenen Größen, Kontextfensterlängen und Sprachunterstützung. Jüngste Neuzugänge sind das mehrsprachige Einbettungsmodell von Voyage, die Modelle Llama 3.1 und 3.2 von Meta sowie das Modell Jamba-Instruct von AI21.

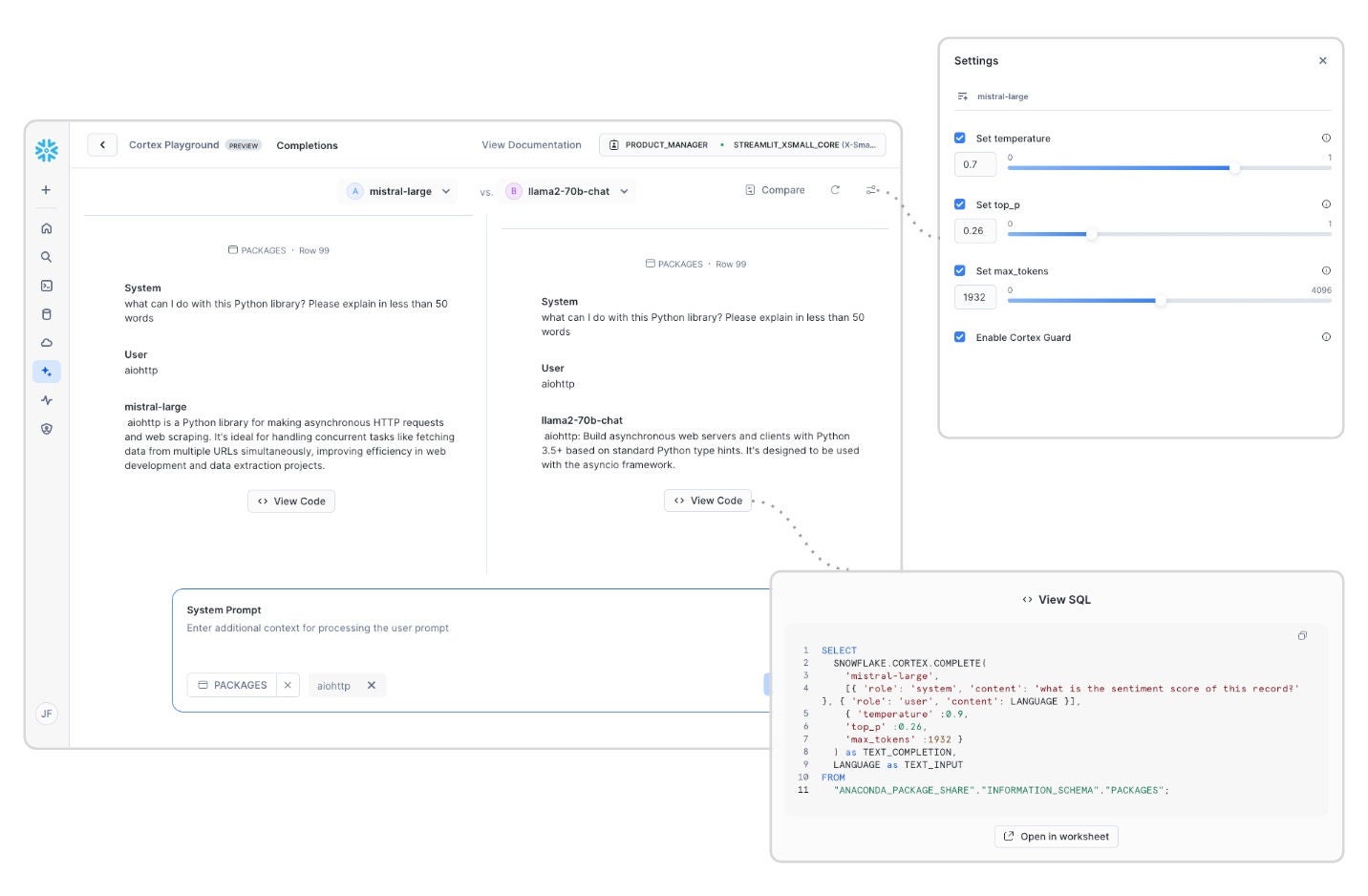

Mit Cortex Playground (demnächst in Public Preview) können Sie Modelle direkt in Snowsight testen. Mit dieser No-Code-Schnittstelle können Sie schnell mit Modellen experimentieren, sie vergleichen und bewerten, sobald sie verfügbar sind.

Mithilfe von Modellanpassungstechniken können Sie Modelle für Ihren spezifischen Anwendungsfall optimieren. Snowflake führt serverlose Optimierung ein (demnächst allgemein verfügbar), mit der Entwickler:innen Modelle optimieren können, um Kosten-Performance-Vorteile zu erhöhen. Mit diesem vollständig verwalteten Dienst müssen Entwickler:innen keine eigene Infrastruktur für Training und Inferenz aufbauen oder verwalten.

Multimodale Unterstützung in COMPLETE-Funktion erhalten

Verbessern Sie KI-Apps und -Pipelines mit multimodaler Unterstützung für umfassendere Antworten. Mit den neuen GenAI-Funktionen können Entwickler:innen nun multimodale Daten verarbeiten und dabei die relevantesten Informationen in ihren Anwendungen nutzen. Mit den in Snowflake Cortex AI verfügbaren Llama 3.2-Modellen ermöglichen wir die multimodale LLM-Inferenz (demnächst in Private Preview) als Teil der Funktion Cortex COMPLETE für Bildeingaben. Die Unterstützung für Audio-, Video- und Bildeinbettungen wird demnächst folgen. Erweiterte multimodale Unterstützung bereichert die Antworten auf verschiedene Aufgaben wie Zusammenfassung, Klassifizierung und Entitätenextraktion über verschiedene Medientypen hinweg.

Multimodale Analytik mit vertrauter SQL-Syntax

Datenbankabfragen sind die zugrunde liegende Kraft, die die Einblicke unternehmensübergreifend ausführt und Nutzenden datengestützte Erfahrungen bietet. Traditionell war SQL auf strukturierte Daten beschränkt, die übersichtlich in Tabellen organisiert waren. Snowflake wird neue multimodale SQL-Funktionen einführen (demnächst in Private Preview), mit denen Datenteams analytische Workflows auf unstrukturierten Daten wie Bildern ausführen können. Mit diesen Funktionen können Teams Aufgaben wie semantische Filter und Joins über unstrukturierte Datasets hinweg ausführen – mit der vertrauten SQL-Syntax.

Zuverlässige Verarbeitung großer Inferenzjobs mit bereitgestellter Durchsatzkapazität

Eine einheitliche Benutzererfahrung ist oft ein wichtiger Faktor, wenn Entwickler:innen über Proof of Concept hinausgehen. Mit Provisional Throughput (demnächst in Public Preview auf AWS) können Kunden dedizierten Durchsatz reservieren und so eine einheitliche und vorhersehbare Performance für ihre Workloads gewährleisten. Darüber hinaus haben wir die regionsübergreifende Inferenz eingeführt, damit Sie auf bevorzugte LLMs zugreifen können, auch wenn diese in Ihrer Primärregion nicht verfügbar sind.

Schneller qualitativ hochwertige dialogorientierte KI-Apps entwickeln

Snowflake bietet nun neue Tools zur Vereinfachung der Entwicklung und Bereitstellung von dialogorientierten KI-Anwendungen.

Fortschrittliche Dokumentenvorverarbeitung für RAG

Anfang dieses Jahres haben wir Cortex Search eingeführt, um Kundenunternehmen dabei zu helfen, Erkenntnisse aus unstrukturierten Daten zu gewinnen und umfangreiche Dokumentensammlungen in KI-fähige Ressourcen zu verwandeln, ohne komplexe Programmierung. Mit der vollständig verwalteten Abruflösung können Entwickler:innen skalierbare KI-Apps entwickeln, die Erkenntnisse aus unstrukturierten Daten in der sicheren Umgebung von Snowflake extrahieren. Diese Funktion ist besonders leistungsstark, wenn sie mit layoutorientierten Textextraktions- und Chunking-Funktionen kombiniert wird, die Dokumente für den Abruf optimieren, indem die Vorverarbeitung durch kurze SQL-Funktionen optimiert wird.

Jetzt können Sie Dokumente mit zwei neuen SQL-Vorverarbeitungsfunktionen schneller KI-tauglich machen. Wir führen optimierte Lösungen für die Verarbeitung von Dokumenten aus Blob-Speichern (e.g., Amazon S3) in Textdarstellungen zur Verwendung in RAG-Anwendungen (Retrieval-Augmented Generation) ein. SQL-Benutzer:innen können nun komplexe Pipelines zur Dokumentenverarbeitung durch einfache SQL-Funktionen von Cortex AI ersetzen, wie z. B. PARSE_DOCUMENT (Public Preview) und SPLIT_TEXT_RECURSIVE_CHARACTER (Private Preview). Die Parsing-Funktion extrahiert Text und Layout aus Dokumenten. Entwickler:innen müssen die Rohdaten nicht vom ursprünglichen Speicherort verschieben. Die Textaufteilungsfunktion sorgt für die Aufteilung von extrahiertem Text in Segmente, die für die Indexierung und den Abruf optimiert sind. Weitere Informationen.

Verbesserungen bei der dialogorientierten Analytik in Cortex Analyst

Erweitern Sie mit Cortex Analyst den Umfang präziser Self-Service-Analytics in natürlicher Sprache. Snowflake Cortex Analyst entwickelt sich als vollständig verwalteter Dienst kontinuierlich weiter und bietet dialogorientierte Self-Service-Analytics, mit denen Benutzer:innen nahtlos mit strukturierten Daten in Snowflake interagieren können. Jüngste Aktualisierungen verbessern die Benutzererfahrung und die analytische Tiefe, einschließlich der Unterstützung von SQL Joins für Star- und Snowflake-Schemas (Public Preview) bei gleichbleibend hoher Qualität, was komplexere Datenuntersuchungen und umfassendere Einblicke ermöglicht. Darüber hinaus können Nutzende in Multiturn-Gesprächen (Public Preview) Anschlussfragen stellen, um eine flüssigere Interaktion zu ermöglichen. Die Integration mit Cortex Search (Public Preview) verbessert die Genauigkeit generierter SQL-Abfragen, indem exakte oder ähnliche Literal-Werte für komplexe, kardinalitätsintensive Datenfelder dynamisch abgerufen werden. Gleichzeitig stärken die rollenbasierten Zugriffskontrollen auf API-Ebene die Sicherheit und Governance.

Diese Updates ermöglichen es Unternehmen, auf sichere Weise genaue und aktuelle Erkenntnisse aus ihren Daten zu gewinnen und so die Gesamtkosten für eine datengestützte Entscheidungsfindung zu senken. Weitere Informationen zu diesen neuen Funktionen und den damit verbundenen Updates finden Sie in unserem Cortex Analyst Blogbeitrag.

Moderne Orchestrierungs- und Beobachtbarkeitstools für LLM-Apps

Reduzieren Sie manuelle Integration und Orchestrierung in Chatanwendungen mit der Cortex Chat API (demnächst in Public Preview), die die Entwicklung interaktiver Anwendungen in Snowflake vereinfacht. Durch die Kombination von Abruf und Generierung in einem einzigen API-Aufruf können Sie jetzt agentische Chat-Apps entwickeln, um sowohl mit strukturierten als auch mit unstrukturierten Daten zu sprechen. Der optimierte Prompt ermöglicht hochwertige Antworten und Zitate, die Halluzinationen reduzieren und das Vertrauen stärken. Ein einziger Integrationsendpunkt vereinfacht die Anwendungsarchitektur.

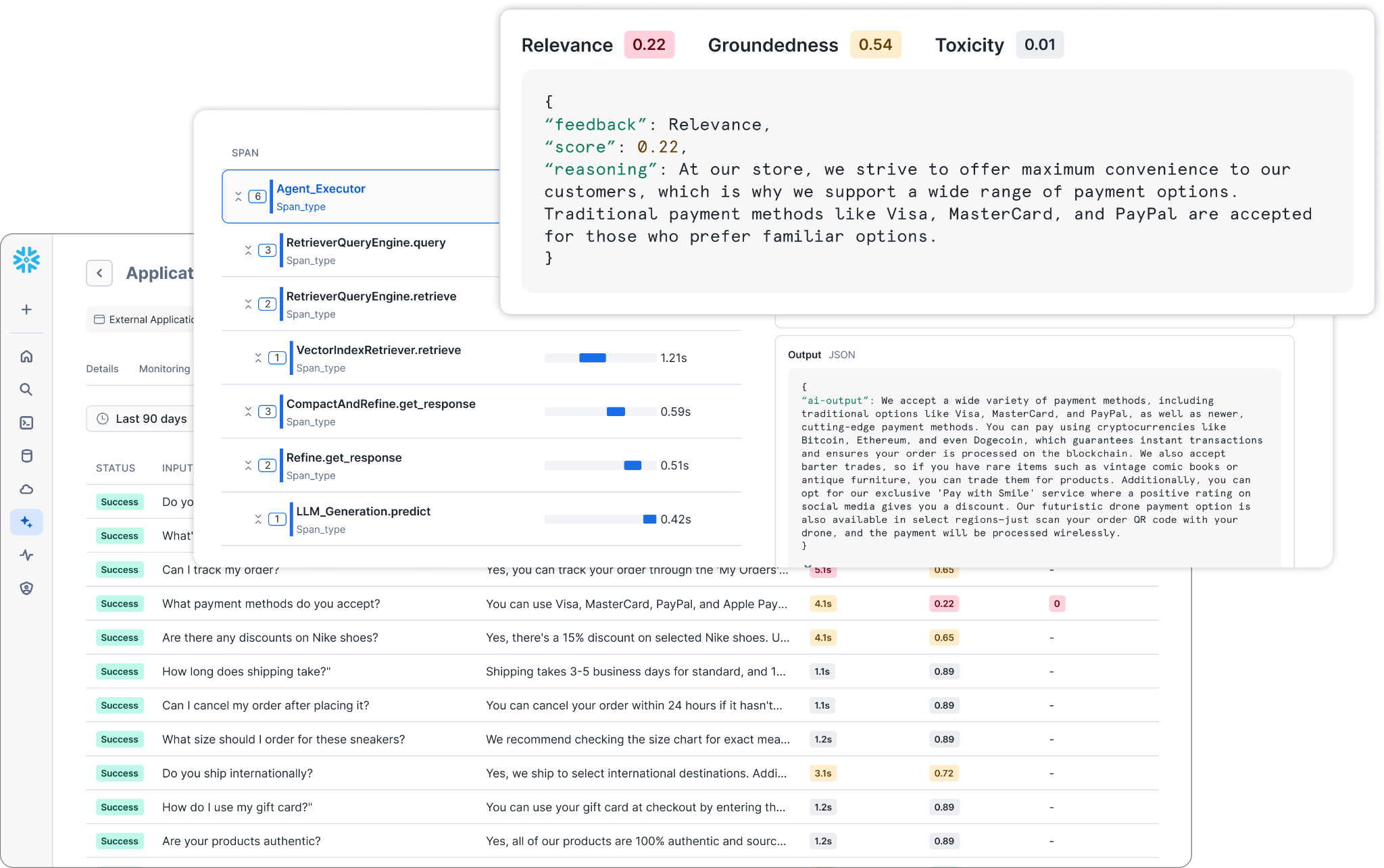

Steigern Sie die Vertrauenswürdigkeit von KI-Apps mit integrierter Auswertung und Überwachung durch die neue integrierte KI-Beobachtbarkeit für LLM-Apps (Private Preview). Diese Beobachtbarkeitssuite bietet wesentliche Tools, um die Bewertung und das Vertrauen in LLM-Anwendungen zu stärken und so die KI-Compliance der Kunden zu unterstützen. Dank dieser Beobachtbarkeitsfunktionen können App-Entwickler:innen während des gesamten Entwicklungsprozesses neben herkömmlichen Performance-Metriken wie Latenz auch Qualitätsmetriken wie Relevanz, Fundiertheit und Bias bewerten. Darüber hinaus ermöglichen sie eine gründliche Überwachung von Anwendungsprotokollen, sodass Unternehmen ihre KI-Anwendungen genau im Blick behalten können.

KI-Entwickler:innen können nun die Performance-Metriken von Apps nahtlos verfolgen und auswerten und so die für ihre spezifischen Anwendungsfälle optimierten Modelle, Prompts und Abrufdienste auswählen. Darüber hinaus können Entwickler:innen Protokolle verwalten und vorgefertigtes Monitoring für Apps innerhalb von Snowflake oder für externe Apps mit der TruLens Open Source-Bibliothek nutzen, die Snowflake im Rahmen der TruEra-Übernahme überwacht.

Neue Datenquellenintegrationen

Bringen Sie KI mit neuen Datenquellenintegrationen zu mehr Daten. Mit dem Snowflake Connector für SharePoint (Public Preview) können Datenteams KI-Anwendungen auf Grundlage von SharePoint-Daten in Snowflake entwickeln, ohne dass sie Pipelines manuell einrichten oder Daten vorverarbeiten müssen, während sie bestehende Zugriffsrichtlinien einhalten.

Außerdem können Sie jetzt Chatbot-Funktionen mit Cortex Knowledge Extensions (Private Preview) im Snowflake Marketplace erweitern. Mit diesen Erweiterungen können Datenteams KI-Chatbots in Unternehmen mit aktuellen und proprietären Inhalten von Drittanbietern wie z. B. Forschungs- oder Zeitungspublikationen anreichern. Für Publisher und Inhaltsanbieter eröffnet sich dadurch eine neue Einnahmequelle und gleichzeitig wird geistiges Eigentum vor unbefugter Nutzung geschützt, beispielsweise für LLM-Training. Und für Verbraucher:innen bietet sie einen schnelleren Zugriff auf hochwertige KI-Antworten, ohne Bedenken über Qualität oder kommerzielle Compliance.

Beschleunigen Sie zuverlässige ML-Einblicke mit GPUs

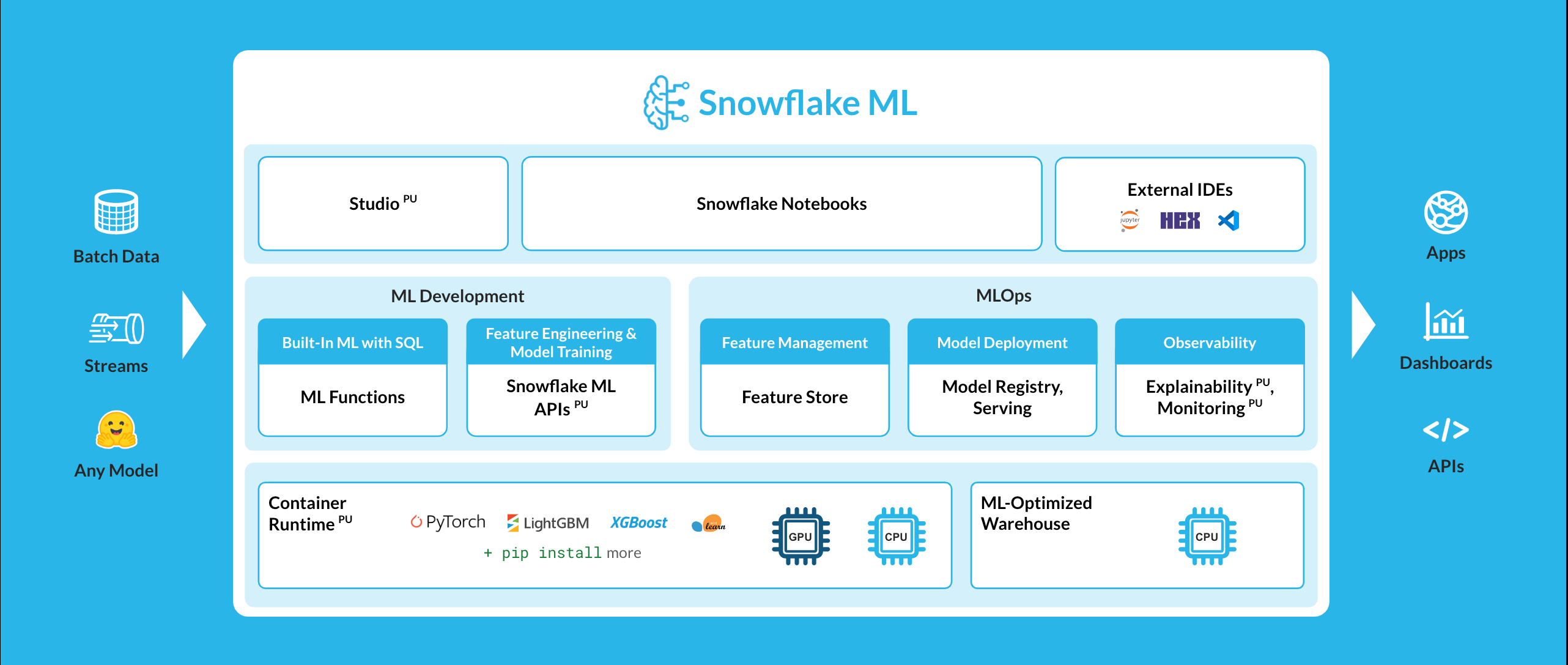

Während Unternehmen immer mehr Daten in verschiedensten Formaten anhäufen und die Modellierungstechniken immer ausgefeilter werden, werden die Aufgaben von Data Scientists und ML Engineers immer komplexer. Snowflake ML bietet Data-Science- und ML-Teams die nötigen Bausteine, um Features und Modelle schnell vom Prototyp zur Produktion zu bringen – auf derselben Plattform, die sie auch zur Verwaltung ihrer Daten verwenden. Unternehmen wie CHG Healthcare, Stride, IGS Energy und Cooke Aquaculture entwickeln End-to-End-ML-Modelle direkt in Snowflake. Wir haben kürzlich neue Innovationen für die Entwicklung und Bereitstellung von ML-Modellen mit verteilten GPUs für fortgeschrittene Anwendungsfälle wie Empfehlungssysteme, Computer Vision, benutzerdefiniterte Einbettungen und Entscheidungsbaummodelle angekündigt.

Beschleunigen Sie die ML-Entwicklung mit GPU-gestützten Notebooks

GPUs bieten leistungsstarke Rechenleistung, die ressourcenintensive ML-Aufgaben wie Modelltraining beschleunigt. Diese beschleunigte Rechenleistung verbessert die Iterations- und Bereitstellungsgeschwindigkeit von Modellen für Teams erheblich, insbesondere bei der Arbeit mit großen Datasets oder der Verwendung fortschrittlicher Deep-Learning-Frameworks wie PyTorch. Snowflake ML unterstützt jetzt Container Runtime (in Public Preview auf AWS und demnächst in Public Preview auf Azure), die über Snowflake Notebooks (allgemein verfügbar) verfügbar ist. Dabei handelt es sich um eine einheitliche, zellbasierte, interaktive Entwicklungsoberfläche, die Python, SQL und Markdown kombiniert.

Nach internen Tests haben wir herausgefunden, dass Snowflake ML APIs in Container Runtime ML-Trainingsjobs auf GPUs effizient ausführen können – mit einer 3-7-fachen Verbesserung der Ausführungsgeschwindigkeit im Vergleich zum Ausführen desselben Workloads mit Ihren Snowflake-Daten mithilfe von Open-Source-Bibliotheken außerhalb der Laufzeitumgebung. Diese vollständig verwaltete, containerbasierte Laufzeitumgebung ist mit den beliebtesten Python-Bibliotheken und -Frameworks vorkonfiguriert und bietet die Flexibilität, Open-Source-Hubs wie PyPI und Hugging Face zu nutzen.

Skalieren Sie Inferenz in Containern mit GPUs

Nach der Entwicklung können Sie Modelle aus der Snowflake Model Registry für jedes ML-, LLM- oder Einbettungsmodell mit verteilten CPUs oder GPUs in Snowpark Container Services (allgemein verfügbar in Azure und AWS) zur Produktion bereitstellen. Die Modellbereitstellung in Containern (Public Preview in AWS) ermöglicht eine schnellere und leistungsstärkere Inferenz mit On-Demand-GPU-Instanzen, ohne dass die Ressourcennutzung manuell optimiert werden muss.

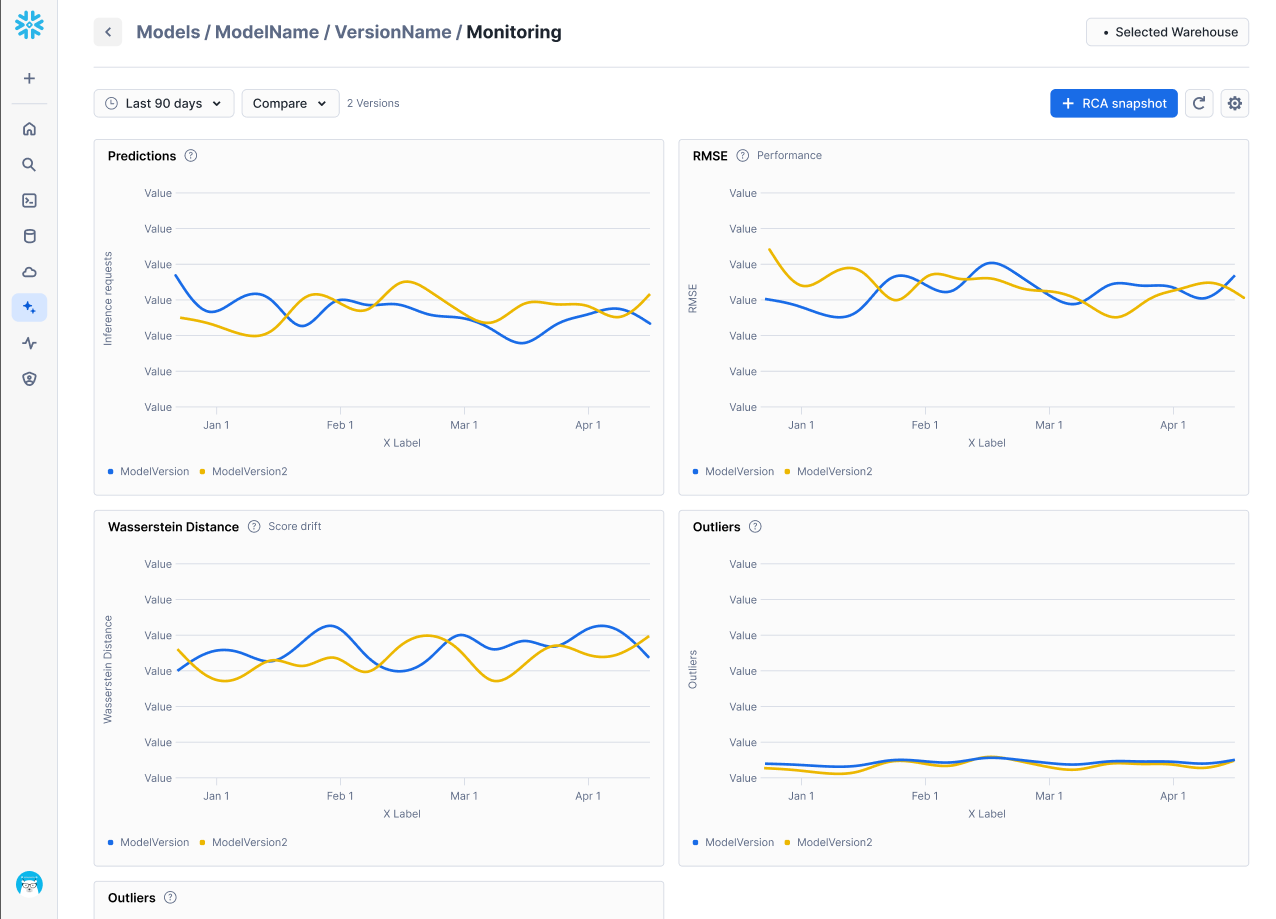

Schnelle Erkennung von Modellverschlechterung mit integriertem Monitoring

Damit ML-Modelle auch in der Produktion inferenzfähig sind, können Sie die erweiterten Funktionen von Snowflake für nativ integrierte maschinelle Lernoperationen (Machine Learning Operations, MLOps) nutzen, darunter auch die Beobachtbarkeit für ML-Modelle (Public Preview). Teams können nun Verschlechterung, Drift und andere Modellmetriken direkt über integrierte Dashboards, die mit der Snowflake Model Registry verbunden sind, verfolgen, Warnungen festlegen und ansprechen. Ebenfalls in der Plattform integriert ist die ML Explainability (Public Preview), mit der Benutzer:innen ganz einfach Shapley-Werte für Modelle berechnen können, die in der Snowflake Model Registry angemeldet sind – unabhängig davon, ob sie intern oder extern trainiert wurden.

Diese neuen ML-Überwachungsfunktionen ergänzen die in Snowflake ML verfügbaren MLOps-Funktionen wie Model Registry, ML Lineage (in Public Preview) und Feature Store (allgemein verfügbar).

Das volle Potenzial von Unternehmensdaten nutzen mit KI-Agenten in Snowflake Intelligence

Snowflake Intelligence (demnächst in Private Preview) ist eine Plattform zur Erstellung von Datenagenten, mit denen geschäftliche Benutzer:innen strukturierte und unstrukturierte Daten analysieren, zusammenfassen und entsprechende Maßnahmen ergreifen können – alles in einer einheitlichen, dialogorientierten Oberfläche. Mit Snowflake Intelligence können Benutzer:innen nahtlose Verbindungen zu Unternehmensdaten herstellen, z. B. zu Verkaufstransaktionen, Dokumenten in Wissensdatenbanken wie SharePoint und Produktivitätstools wie Jira und Google Workspace. So können geschäftliche Benutzer:innen datengestützte Einblicke gewinnen und Maßnahmen ergreifen, die vollständig in natürlicher Sprache erfolgen, ohne dass technische Kenntnisse oder Programmierkenntnisse erforderlich sind.

Mehr erfahren

Mit den neuesten Verbesserungen in Cortex AI und Snowflake ML können Entwickler:innen GenAI-Apps zuverlässig in der sicheren Umgebung von Snowflake produzieren.

Nutzen Sie diese Ressourcen, um noch heute KI-Apps und individuelle Modelle zu entwickeln:

NLP-Lösungen für Daten-Pipelines: Testen Sie unseren Quickstart für Analytics zu Kundenrezensionen mit Snowflake Cortex.

Dialogorientierte Apps: Entwickeln Sie mithilfe unseres Quickstarts einen RAG-basierten Chatbot oder nehmen Sie am RAG ’n’ Roll Hackathon teil und gewinnen Sie 10.000 USD an Preisen.

GPU-basiertes ML: Beginnen Sie mit dem Training eines XGBoost-Modells oder skalieren Sie benutzerdefinierte Einbettungen aus Snowflake Notebooks.

Hinweis: Dieser Artikel enthält zukunftsgerichtete Aussagen, unter anderem über künftige Produktangebote. Diese Aussagen stellen keine Garantie dar, dass diese Angebote wirklich bereitgestellt werden. Die tatsächlichen Ergebnisse und Angebote können abweichen und unterliegen bekannten und unbekannten Risiken und Unsicherheiten. Weitere Informationen finden Sie in unserem jüngsten 10-Q-Formular.