Sviluppare app LLM è semplice, rapido e sicuro con Snowflake Cortex

L’AI generativa e i LLM stanno rivoluzionando il nostro modo di lavorare su scala globale. Snowflake ha il piacere di annunciare un’innovativa lineup che applica alla GenAI tutte le caratteristiche di semplicità d’uso, sicurezza e governance della sua piattaforma. Le nuove funzionalità consentono a tutti gli utenti di incorporare i LLM nei processi di analisi, in pochi secondi, mentre gli sviluppatori possono realizzare app basate su GenAI in pochi minuti o eseguire in poche ore flussi di lavoro avanzati, come l’ottimizzazione dei modelli di base a partire dai dati aziendali, il tutto senza uscire dal perimetro di sicurezza di Snowflake. Grazie a questi progressi, tutti gli sviluppatori e gli analisti di dati possono applicare la GenAI ai dati aziendali, già protetti e governati, indipendentemente dal proprio livello di preparazione ed esperienza.

Ma esaminiamo in dettaglio tutte le funzionalità che gli sviluppatori possono utilizzare per applicare l’AI generativa ai dati aziendali in modo intuitivo e sicuro con Snowflake.

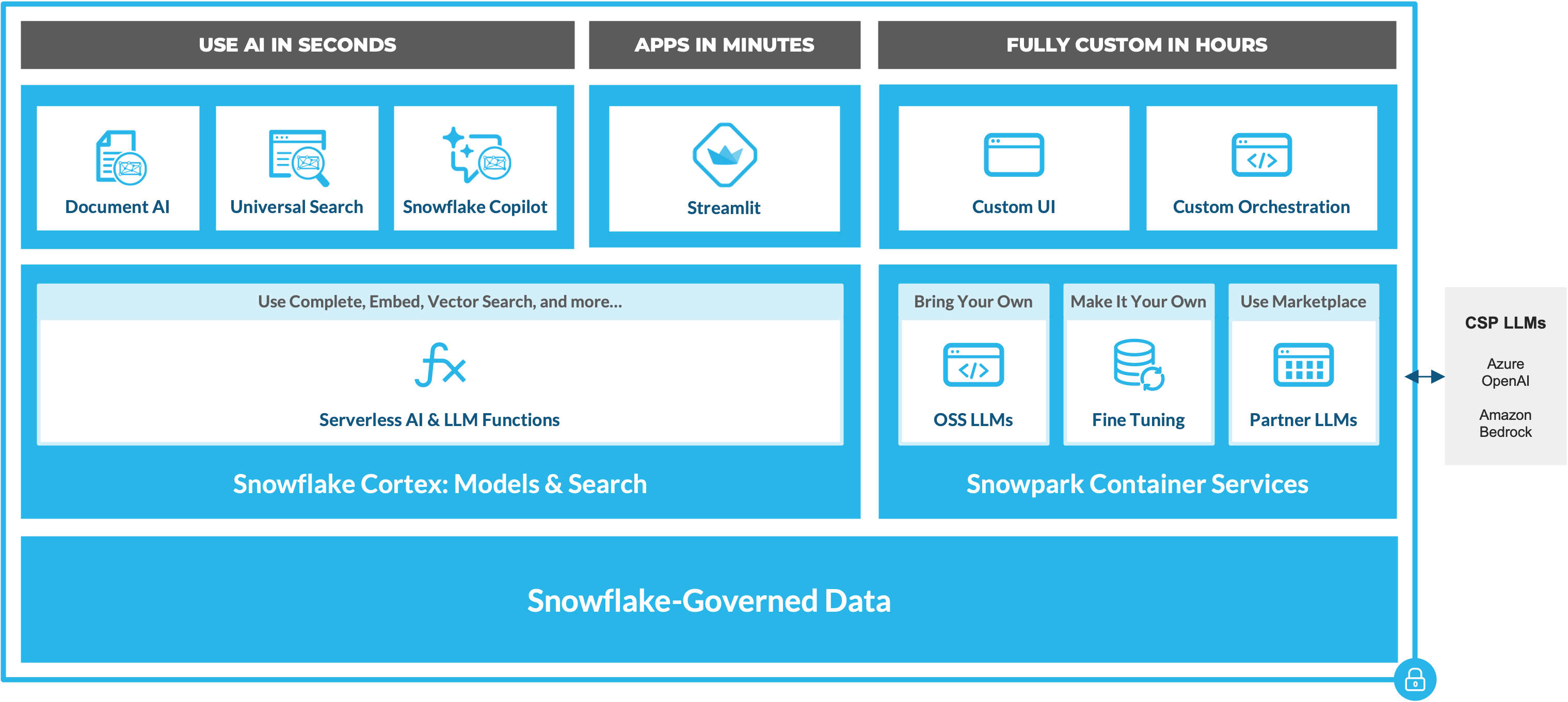

Per applicare l’AI generativa in tutta sicurezza ai propri dati governati, i clienti Snowflake possono utilizzare due componenti di base:

Snowflake Cortex: Snowflake Cortex (disponibile in private preview) è un servizio intelligente e completamente gestito che consente di accedere a modelli AI, LLM e funzionalità di ricerca vettoriale leader di settore, per analizzare i dati e realizzare applicazioni AI in tempi brevissimi. Per consentire alle aziende di creare velocemente app LLM in grado di comprendere i loro dati, Snowflake Cortex permette agli utenti di accedere a una serie di funzioni serverless in continua espansione, che consentono di applicare l’inferenza ai LLM generativi leader di settore, come il modello Llama 2 di Meta AI, a modelli dedicati ad attività specifiche, per accelerare le analisi dei dati, e ad avanzate funzionalità di ricerca vettoriale.

Ma i vantaggi di Snowflake Cortex non vanno solo a beneficio degli sviluppatori, perché questo servizio è anche alla base delle esperienze LLM-powered, che includono un’interfaccia utente dotata di funzionalità complete, come Document AI, Snowflake Copilot e Universal Search, tutte attualmente disponibili in private preview.

Snowpark Container Services: questo runtime Snowpark aggiuntivo (che sarà disponibile a breve in public preview in alcune regioni AWS) consente agli sviluppatori di distribuire, gestire e dimensionare in modo semplice e intuitivo modelli e workload containerizzati per attività come l’ottimizzazione dei modelli LLM open-source, utilizzando l’infrastruttura gestita di Snowflake con le istanze GPU, il tutto entro il perimetro del proprio account Snowflake. Scopri di più e ricevi gli aggiornamenti.

Grazie a questi due componenti, gli sviluppatori hanno infinite possibilità di realizzare app LLM senza trasferire i dati all’esterno del perimetro governato da Snowflake.

Usare l’AI in pochi secondi

Per offrire a tutti la possibilità di accedere ai dati aziendali e all’AI, estendendo l’adozione oltre la ristretta cerchia degli esperti, Snowflake offre innovazioni alla portata di qualunque utente, per sfruttare modelli LLM all’avanguardia senza richiedere integrazioni personalizzate o lo sviluppo di front-end. Questo include esperienze complete incentrate sull’interfaccia utente, come Snowflake Copilot, e l’accesso a funzioni SQL e Python basate su LLM, che permettono di accelerare gli analytics a costi contenuti, con modelli generici e specializzati disponibili tramite Snowflake Cortex. Scopri di più qui.

Creare app LLM con i vostri dati nell’arco di pochi minuti

Ora gli sviluppatori possono realizzare app LLM che imparano, nell’arco di pochi minuti, tutte le sfumature uniche dei loro dati e del loro business, senza richiedere integrazioni, distribuzioni manuali di LLM, né la gestione di un’infrastruttura basata su GPU. Per creare queste applicazioni LLM personalizzate con i loro dati, utilizzando la Retrieval Augmented Generation (RAG) in modo nativo all’interno di Snowflake, gli sviluppatori possono utilizzare:

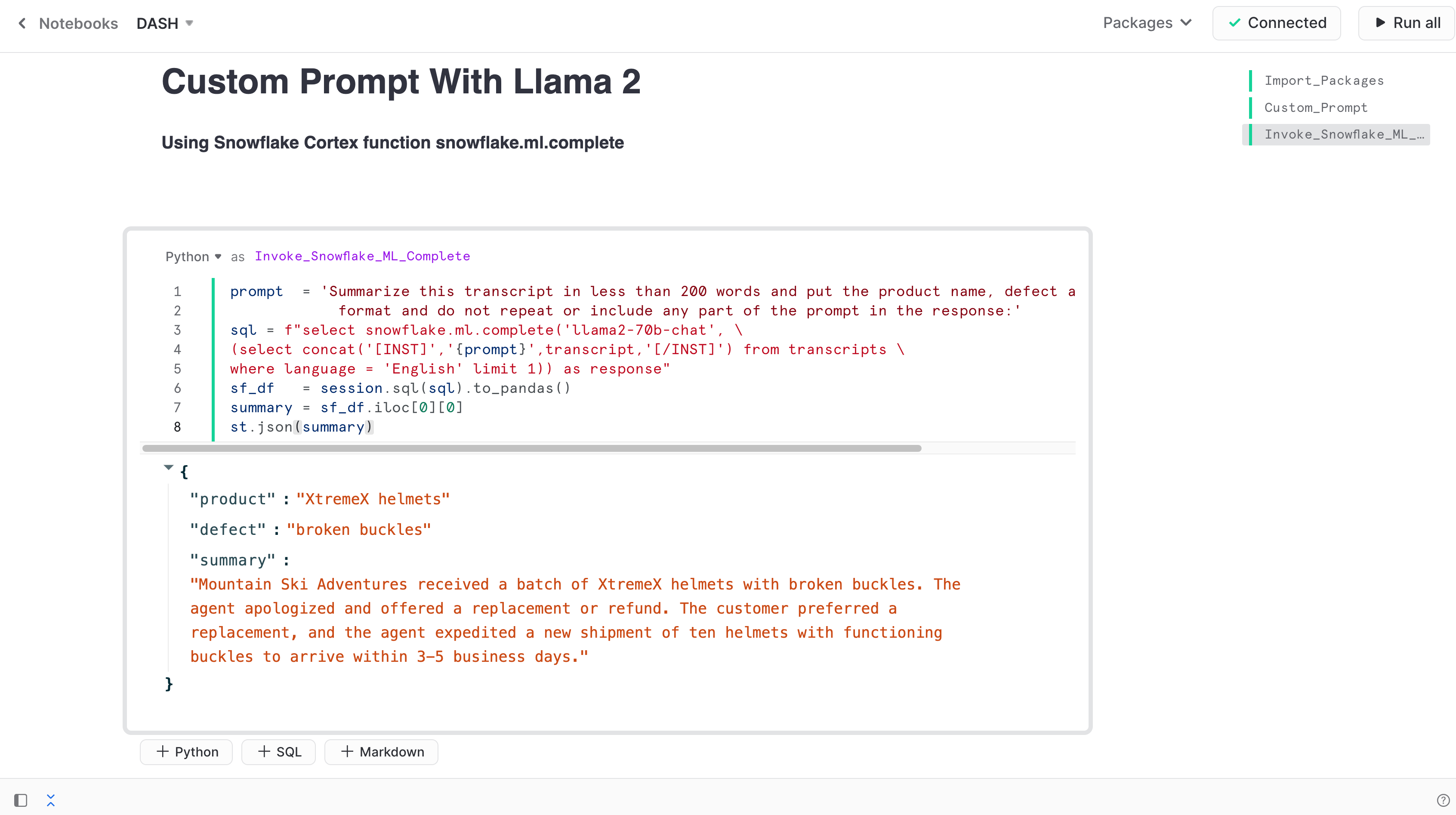

Funzioni di Snowflake Cortex: essendo un servizio completamente gestito, Snowflake Cortex offre a tutti i clienti la possibilità di accedere agli elementi fondamentali necessari per sviluppare app LLM, senza essere costretti a gestire un’infrastruttura complessa.

Offre ad esempio una serie di funzioni generiche in grado di sfruttare sia i LLM open source leader di settore che i LLM proprietari con performance elevate, per semplificare la progettazione dei prompt a supporto di una vasta gamma di casi d’uso. I modelli iniziali includono:

- Complete (in private preview): gli utenti possono passare un prompt e selezionare il modello LLM che desiderano utilizzare. Per la private preview, gli utenti avranno la possibilità di scegliere fra tre diverse taglie (7 B, 13 B e 70 B) di Llama 2.

- Text to SQL (in private preview): genera SQL a partire dal linguaggio naturale, utilizzando lo stesso modello LLM Snowflake alla base dell’esperienza di Snowflake Copilot.

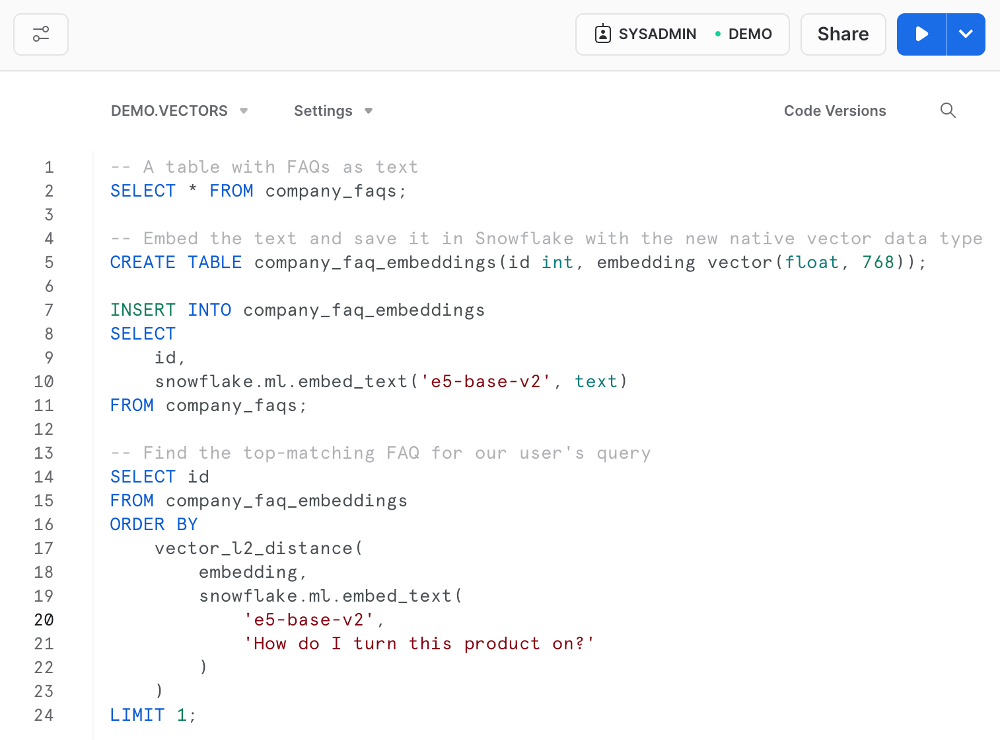

Offre inoltre funzionalità per l’integrazione di vettori e ricerca semantica, per consentire agli utenti di contestualizzare agevolmente le risposte dei modelli con i loro dati, per creare app personalizzate in pochi minuti.

- Embed Text (disponibile a breve in private preview): questa funzione trasforma l’input di testo ricevuto in embedding vettoriali, utilizzando un modello di embedding selezionato dall’utente.

- Vector Distance (disponibile a breve in private preview): per calcolare la distanza fra i vettori, gli sviluppatori potranno scegliere fra tre funzioni diverse, ovvero similarità coseno (vector_cosine_distance()), norma L2 (vector_l2_distance()) e prodotto interno (vector_inner_product()).

- Native Vector Data Type (disponibile a breve in private preview): per consentire l’esecuzione di queste funzioni con i vostri dati, ora Snowflake supporta in modo nativo anche i tipi di dati vettoriali, in aggiunta agli altri tipi di dati già supportati.

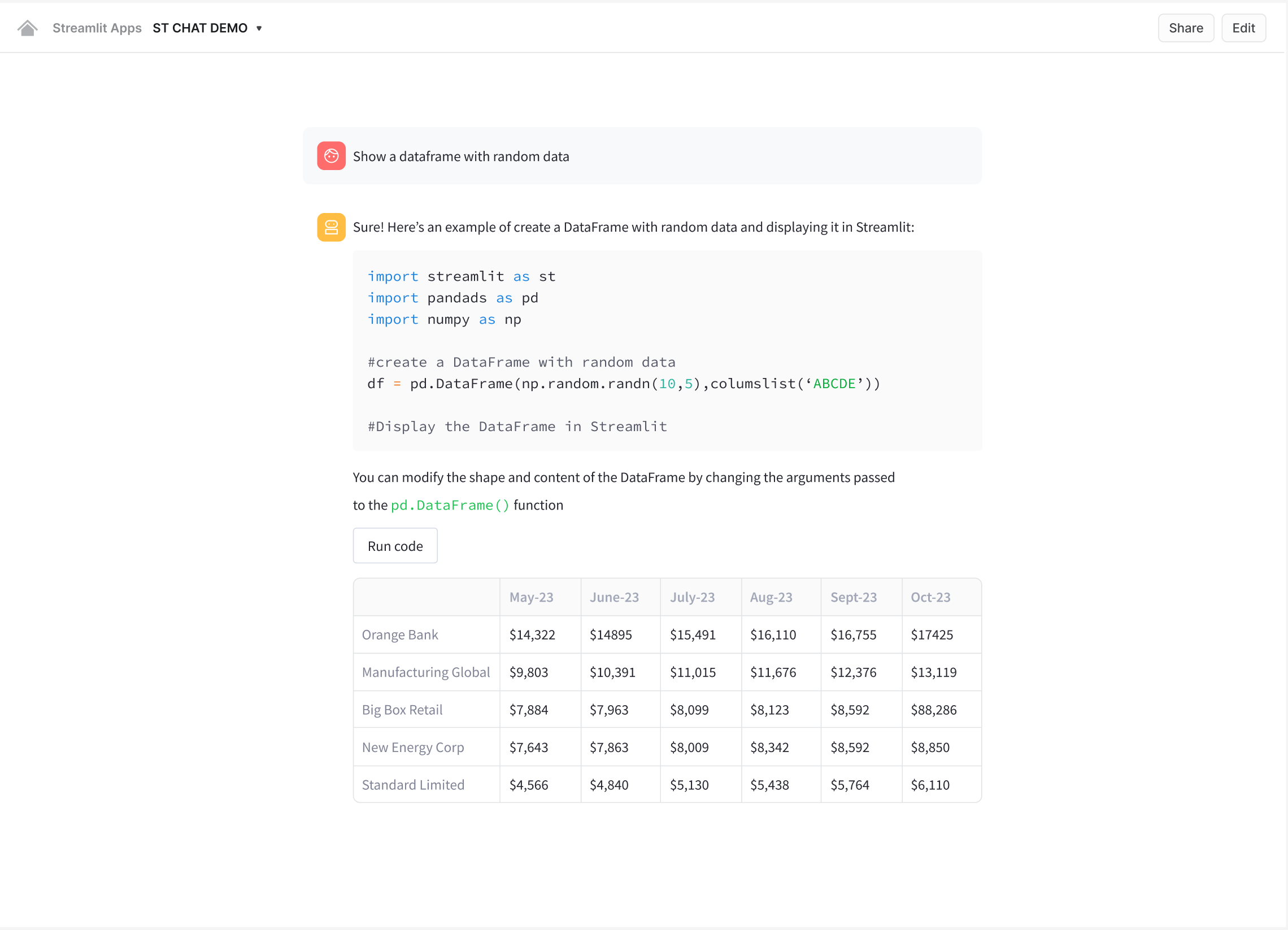

Streamlit in Snowflake (public preview): Streamlit consente ai team di accelerare ulteriormente la creazione delle app LLM, grazie alla possibilità di sviluppare interfacce con poche righe di codice Python, anche senza esperienza di sviluppo front-end. Tali app possono essere quindi distribuite e condivise in tutta sicurezza all’interno dell’azienda, tramite URL univoci che sfruttano i controlli di accesso basati sul ruolo in Snowflake e possono essere generati con un semplice clic. Scopri di più qui.

Snowpark Container Services: sviluppare interfacce utente personalizzate, ottimizzare i modelli LLM open source e molto altro ancora

Con Snowpark Container Services (disponibile a breve in public preview in alcune regioni AWS), Snowflake offre agli sviluppatori opportunità di sviluppo e distribuzione praticamente illimitate per personalizzare ulteriormente le applicazioni LLM. Questa nuova opzione runtime di Snowpark consente agli sviluppatori di distribuire, gestire e scalare facilmente workload containerizzati (processi, servizi e funzioni dei servizi) tramite l’infrastruttura Snowflake, sicura e gestita, con opzioni hardware configurabili, come le GPU NVIDIA.

Di seguito sono riportati alcuni degli adattamenti più comuni che gli sviluppatori possono effettuare sulle app LLM senza essere costretti a spostare i dati al di fuori del perimetro governato e sicuro di Snowflake.

- Distribuzione e ottimizzazione di database vettoriali e modelli LLM open source: utilizzando un’infrastruttura basata su GPU insieme a Snowpark Model Registry, è facile distribuire, ottimizzare e gestire qualunque modello LLM open source o eseguire un database vettoriale open source, come Weaviate, con la tipica semplicità di Snowflake ed entro il perimetro sicuro dell’account.

- Uso di app, modelli LLM e database vettoriali commerciali: l’integrazione in private preview con le Snowflake Native App consente di utilizzare Snowpark Container Services per eseguire integralmente app sofisticate nell’account Snowflake, per esempio LLM commerciali di AI21 Labs o Reka.ai, notebook all’avanguardia come Hex, avanzati strumenti LLMOps di Weights & Biases, database vettoriali come Pinecone e molto altro ancora. Per scoprire di più sulle ultime novità per lo sviluppo di applicazioni in Snowflake, fai clic qui.

- Sviluppo di interfacce utente personalizzate per le app LLM: Snowpark Container Services offre la massima flessibilità agli sviluppatori di applicazioni LLM aziendali. Per creare front-end personalizzati utilizzando framework come ReactJS, basta implementare un’immagine container con il relativo codice per renderla disponibile in Snowflake.

Risorse utili per iniziare

Snowflake offre a tutti gli utenti la possibilità di sfruttare i modelli LLM e l’intelligenza artificiale per estrarre valore in modo semplice, veloce e sicuro dai loro dati aziendali. Che tu abbia l’esigenza di cominciare a utilizzare l’intelligenza artificiale in pochi secondi, o di realizzare app LLM personalizzate con la massima flessibilità in pochi minuti, Snowflake Cortex, Streamlit e Snowpark Container Services forniscono tutti i blocchi costitutivi necessari senza costringerti a spostare i dati all’esterno del perimetro governato e sicuro di Snowflake. Per altre informazioni utili per cominciare, consulta:

- Creare app utilizzando Streamlit in Snowflake

- Snowpark Container Services: distribuire ed eseguire in modo sicuro AI generativa e app full-stack in Snowflake con informazioni e aggiornamenti per la public preview

- Per richiedere le preview, contatta il team commerciale Snowflake.